AIの紹介

最近話題の「生成AI」は、従来のAIが保有するデータの範囲内でしか回答できなかったのに対し、新たに回答を生成できることが特徴です。例えば「夏にさっぱりしたものが食べたい」といった曖昧な問いにも対応できます。中でも言語を中心とした「大規模言語モデル(LLM)」が、ビジネスの現場で期待されています。

生成AIは、ニューラルネットワークという脳の神経細胞を模した構造で構成されています。言語や画像、音声などの大量データをトークン化・ベクトル化し、行列演算をかけることによってニューラルネットワークを構築していきます。会社の情報や業界情報などの機密情報を活用したい場合、ファインチューニング(追加学習)することで、ニューラルネットワークを改造して使用していくというステップになります。

このすべてのプロセスでは、高性能な計算能力を持つGPUが必要になります。

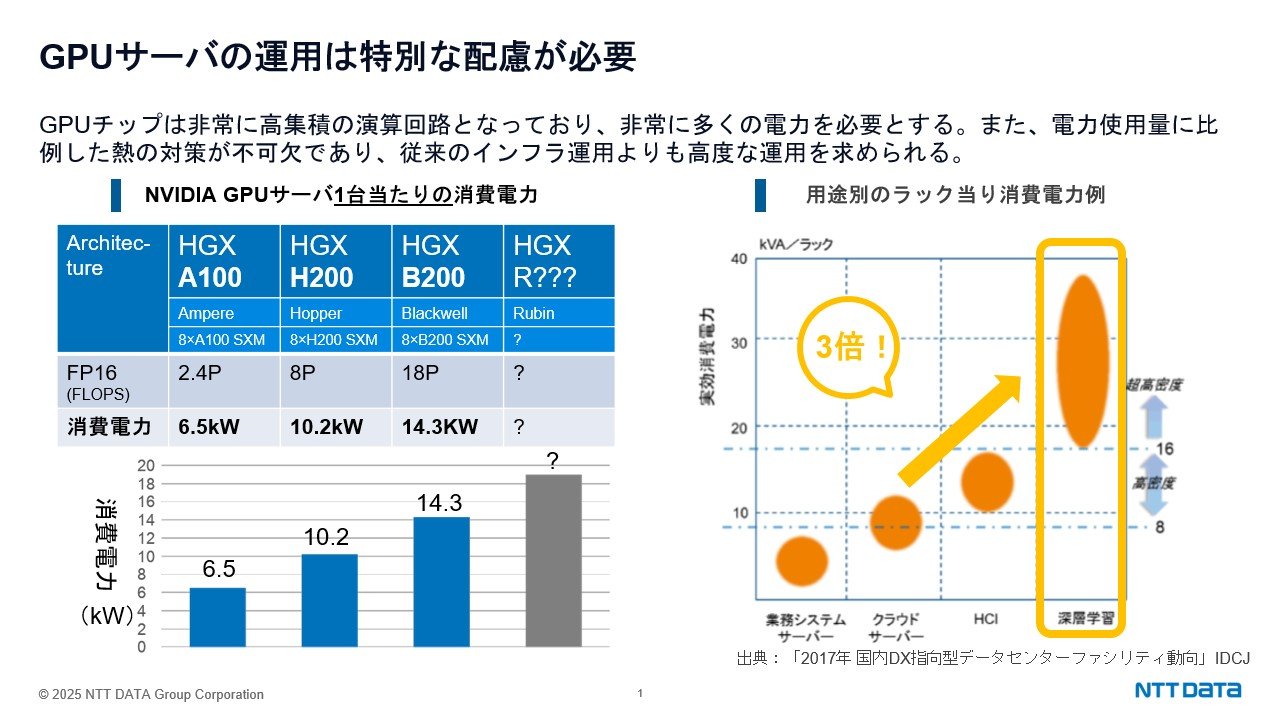

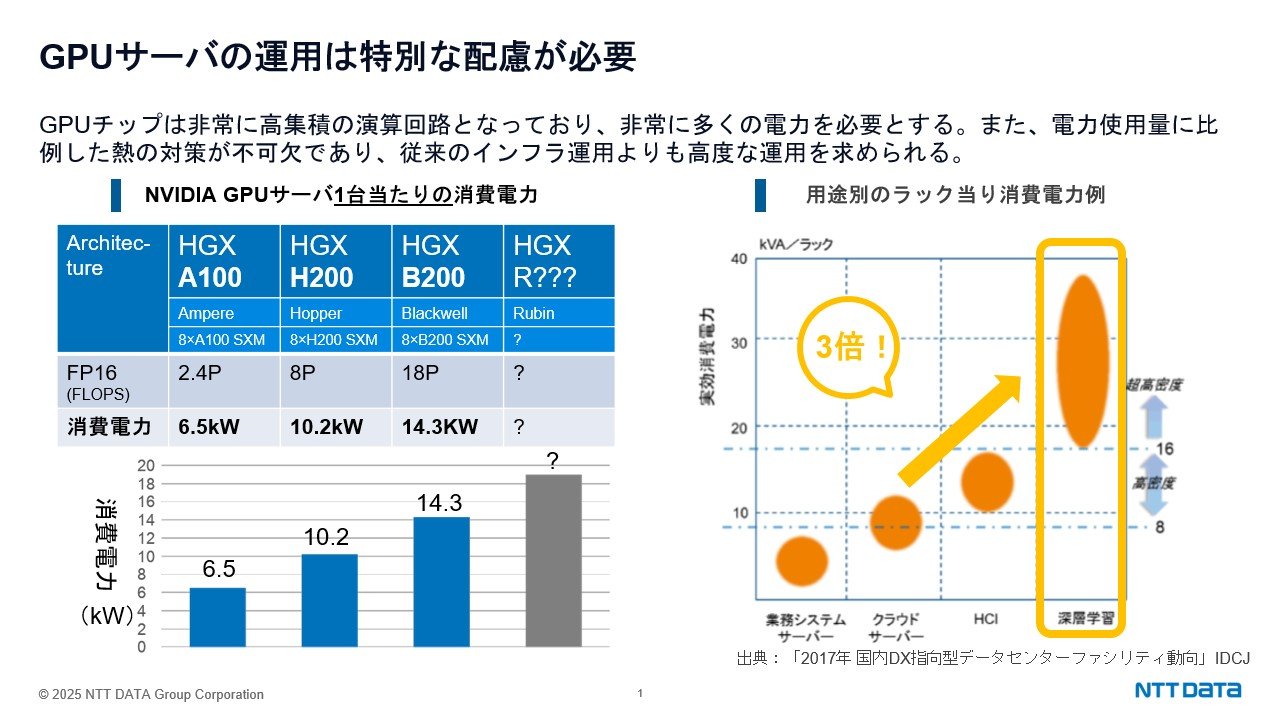

GPUは膨大な単純計算を並列処理するのが得意で、AI学習に最適です。しかし非常に高集積の演算回路となっているため消費電力が非常に大きく、熱も発生します。たとえばNVIDIAのチップを搭載したGPUサーバ1台の消費電力をスライドで示しています。チップの世代が更新されるごとに消費電力も上がってきており、GPUサーバを運用する要件としては、冷却や電力供給のための特殊な配慮が求められます。

AI基盤の選択肢

AI基盤の選択肢としては、パブリッククラウド、プライベートクラウド、オンプレミスの大きく3つがあります。

まずクラウドとオンプレミスを比較します。オンプレミスでお客様がAIを作っていく場合、企画から保守運用まで非常に多くのステップを必要とします。クラウドに移行することで、DC設計、ハードウェア設計、保守運用というステップを省略できるのが大きなメリットです。ソフトウェア設計とソフトウェア構築に関しても、弊社の別のサービスをご利用いただくことでご支援可能です。

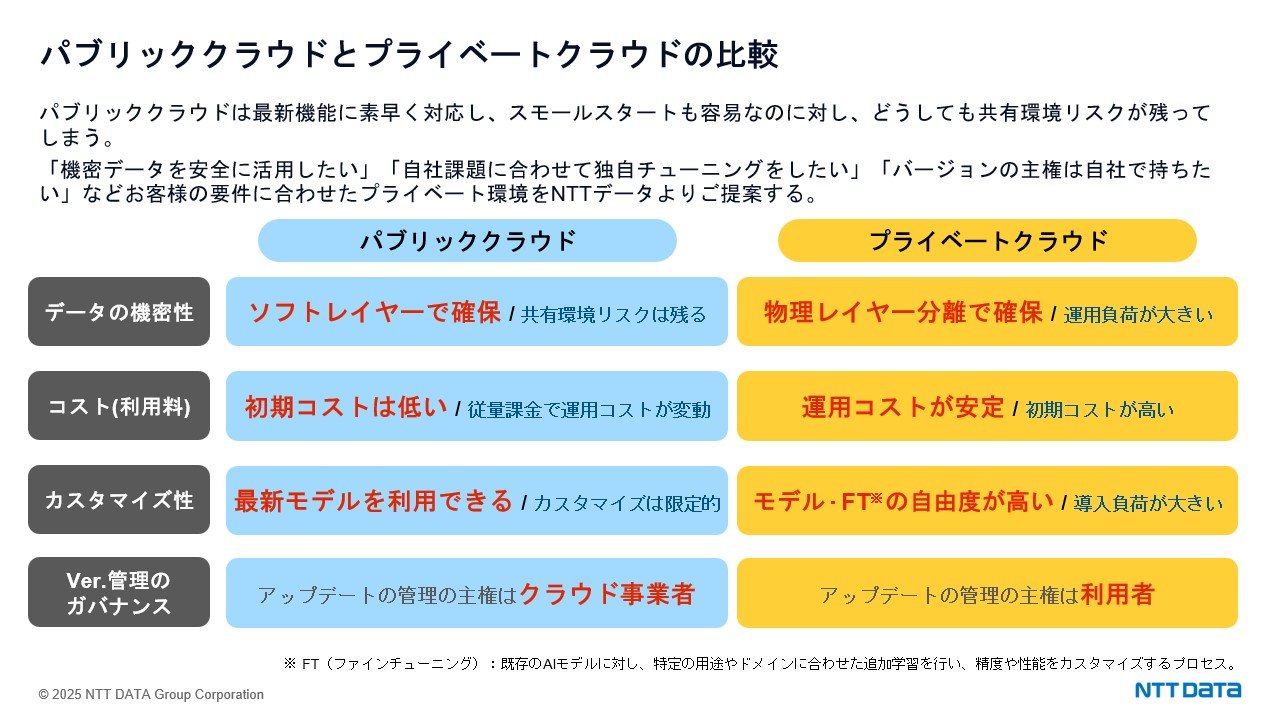

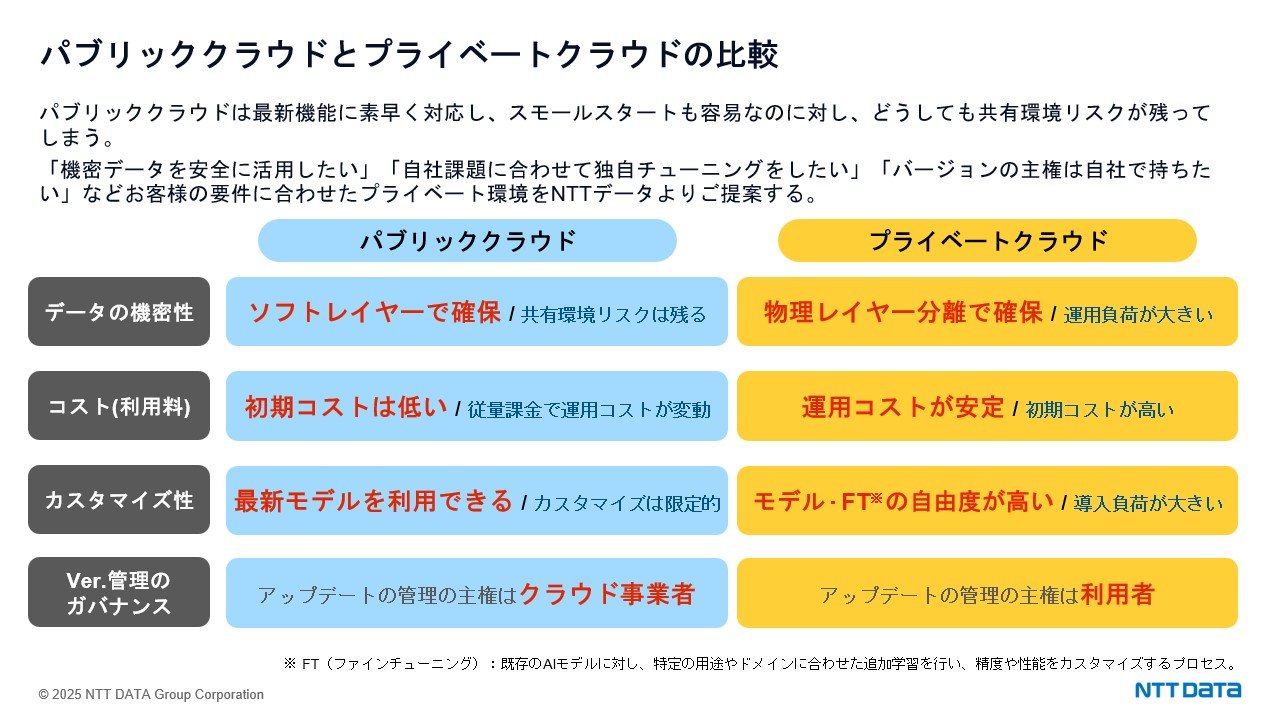

次にパブリッククラウドとプライベートクラウドを比較します。

1番大きな差はデータの機密性の違いです。パブリッククラウドがソフトレイヤーでお客様ごとの環境を管理・確保しているのに対し、プライベートクラウドは物理レイヤーで分離・確保できるところが大きな違いです。パブリッククラウドも安全でセキュリティ対策は万全なものの、起こりうるのが人意的なミスによる情報流出です。プライベートクラウドはそういったリスクを限りなくゼロにできます。

コスト面ではパブリッククラウドは初期コストが低く従量課金型で変動費的な使い方ができます。プライベートクラウドは運用コストが安定し固定費型の使い方ができます。 GPUは使い方によって非常に高額になる場合もあるので、コストが安定化する方がお客様の意思決定もしやすいと思います。

カスタマイズやバージョン管理の観点ではパブリッククラウドでは常に最新モデルを利用できるメリットがある反面、不意のアップデートにより多大な工数が発生することがあります。一方、プライベートクラウドは、アップデートの管理主権はお客様側にありますので、この点も大きなメリットといえます。

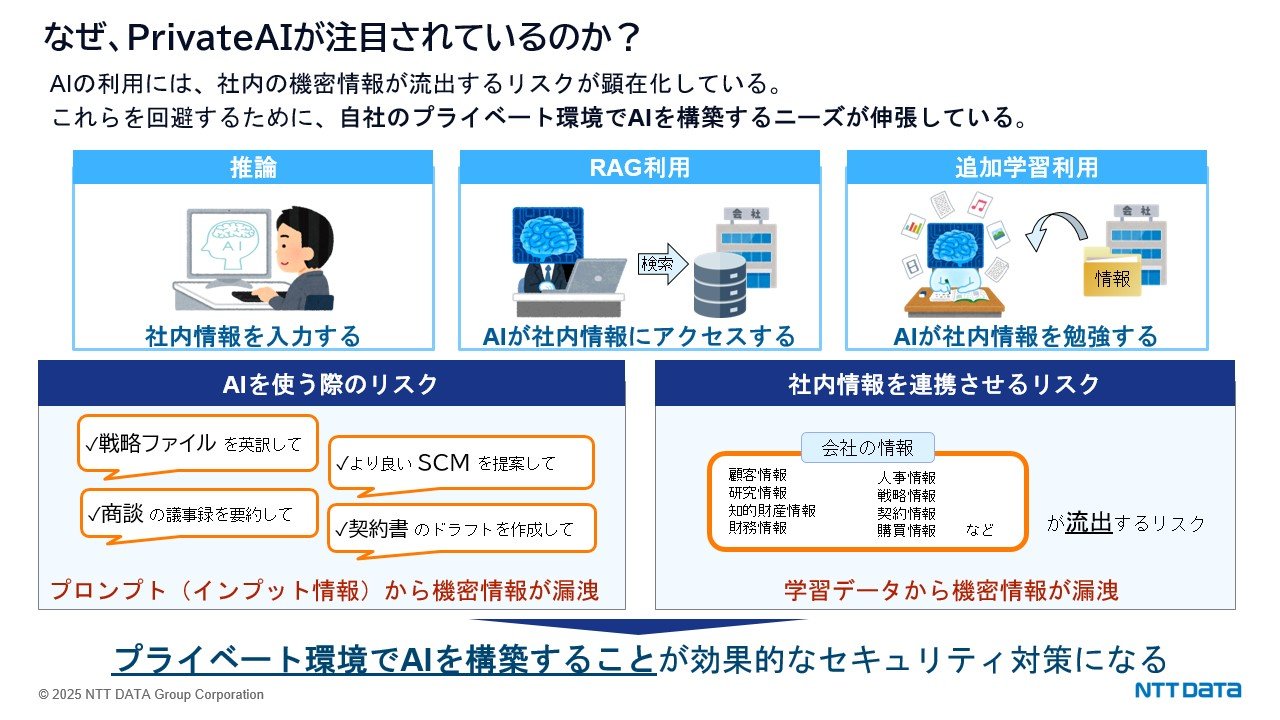

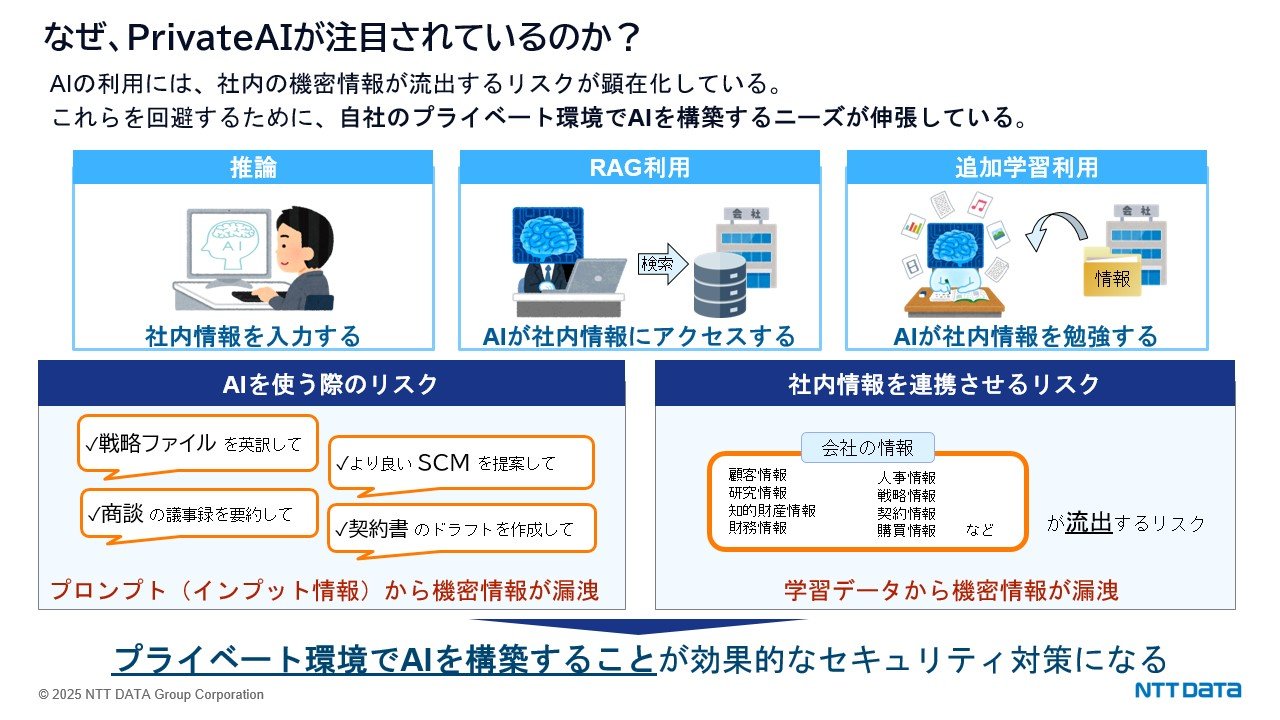

次にプライベートAI、つまりプライベート環境でのAI構築のメリットをご紹介します。

AIの利用には常に社内の機密情報の流失リスクが潜んでいます。たとえば従業員の質問内容が機密情報にふれるものであった場合や、社内の機密情報(顧客情報、研究情報など)とAIを連携させた場合には流出のリスクがあります。これらのリスクを最小限に抑えるためには、プライベート環境のAI構築が有効です。

NTTデータは、セキュリティ、コスト、運用負荷のバランスを考慮し、「プライベートクラウド」の提案をしています。

NTTデータが提供する基盤サービスの紹介

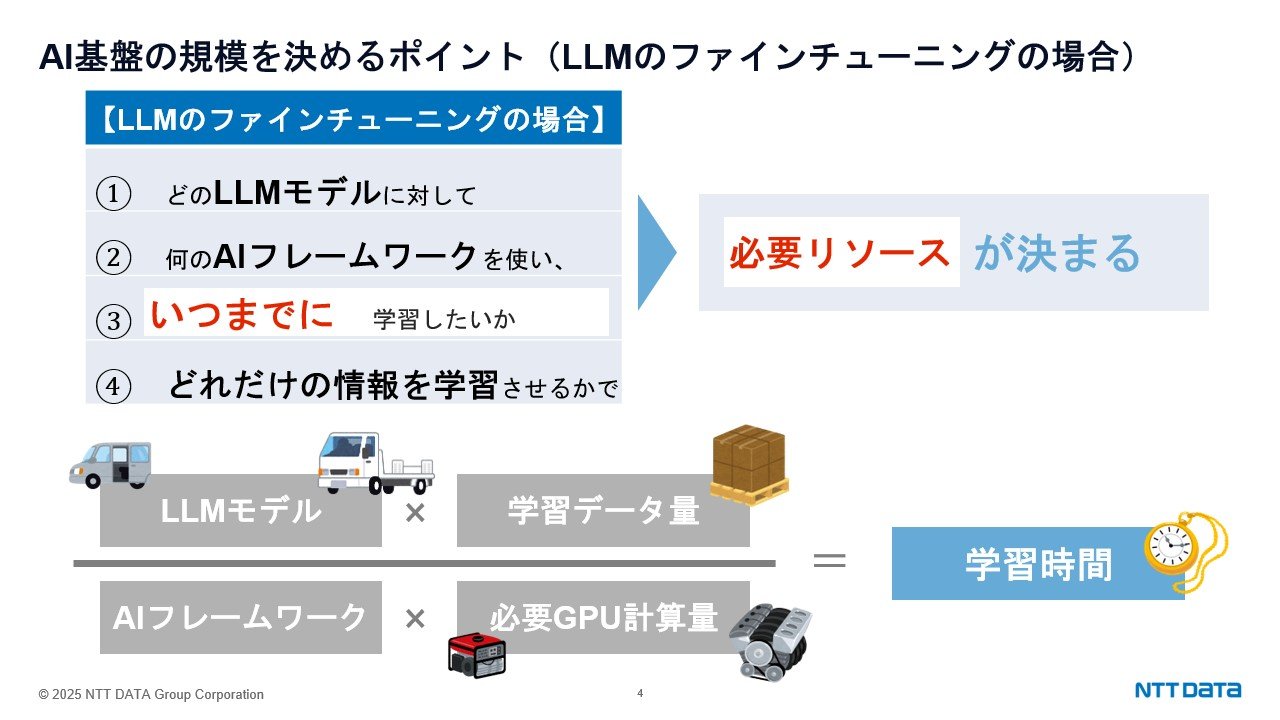

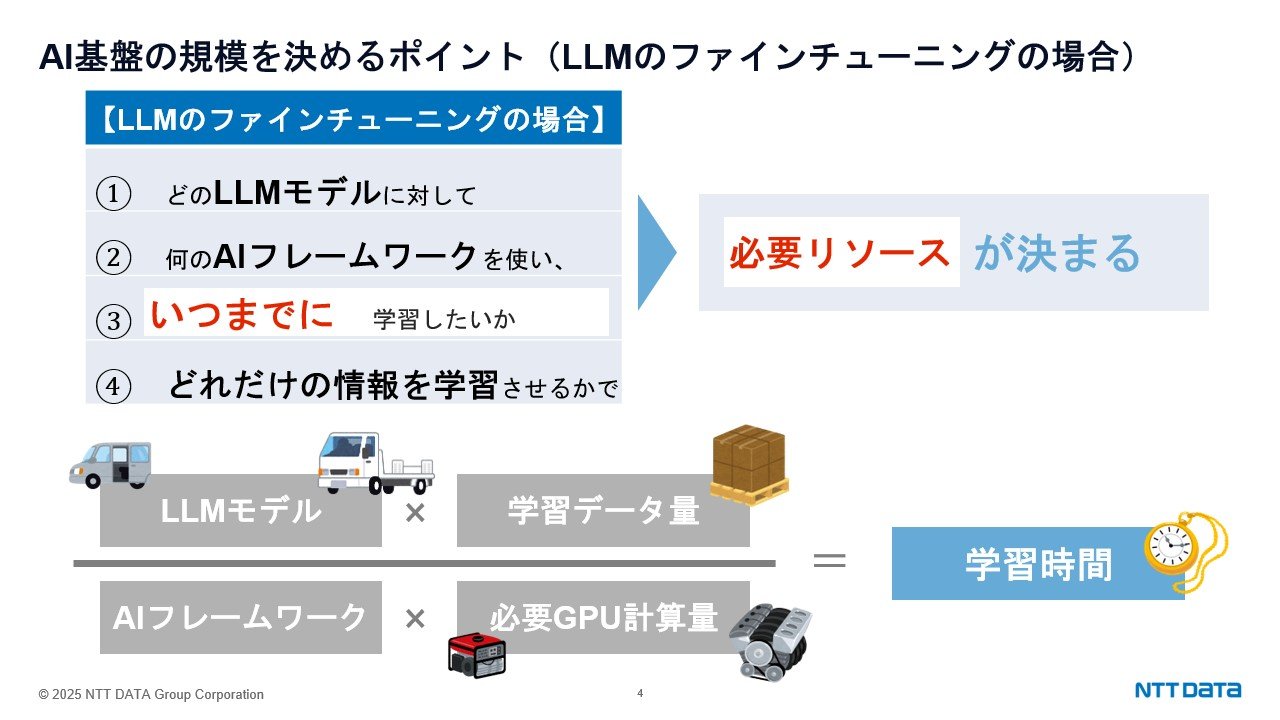

次に必要なGPU計算量を決めるにあたってのポイントをご紹介します。ファインチューニングを例にとると以下の4要素で学習時間が決まります。

・LLMモデル

・AIフレームワーク

・GPUリソース

・学習データ量

この関係を車に例えると「LLMモデル=車体(重量)」「学習データ量=積載量」「GPU=エンジン」そして「学習時間=輸送時間」となります。これを入れ替えると、どれだけの時間で学習させたいかによって、GPUの計算量が決まってきます。

AIの利用シーンにより、必要となるGPU環境の規模は異なります。NTTデータでは、計算量の多様なニーズに柔軟に対応するため、推論環境、ファインチューニング環境、学習環境、大規模学習環境に対応したサービス拡充を進めています。

ここではすでにサービス開始しているファインチューニング環境についてご紹介させていただきます。

想定ユースケースとしてはインファレンス(推論)としてのLLMやRAGの活用、あるいは軽量LLMモデルのファインチューニング(追加学習)などがあります。NTTデータの優位性としては、NTT版のLLM「tsuzumi」をご利用いただけること、リアドア型水冷式ラック冷却機によりGPUサーバを集約運用できること、そして再生可能エネルギーを利用可能なDC環境などがあります。

今後はより小規模なGPU需要にもお応えできるようサービス拡張を予定しています。

サービスの概要としては、サーバの計算量の提供とネットワーク接続サービスに、監視・保守をセットにした形でご提供します。弊社のプライベートクラウド「OpenCanvas」とも連携を視野に入れています。GPUの収容環境は東京都三鷹市にあるNTTデータのフラッグシップデータセンターです。こちらは外気冷房による省エネ設計に加え、2025年中には再エネ100%運用を予定している、環境配慮型の最新データセンターです。

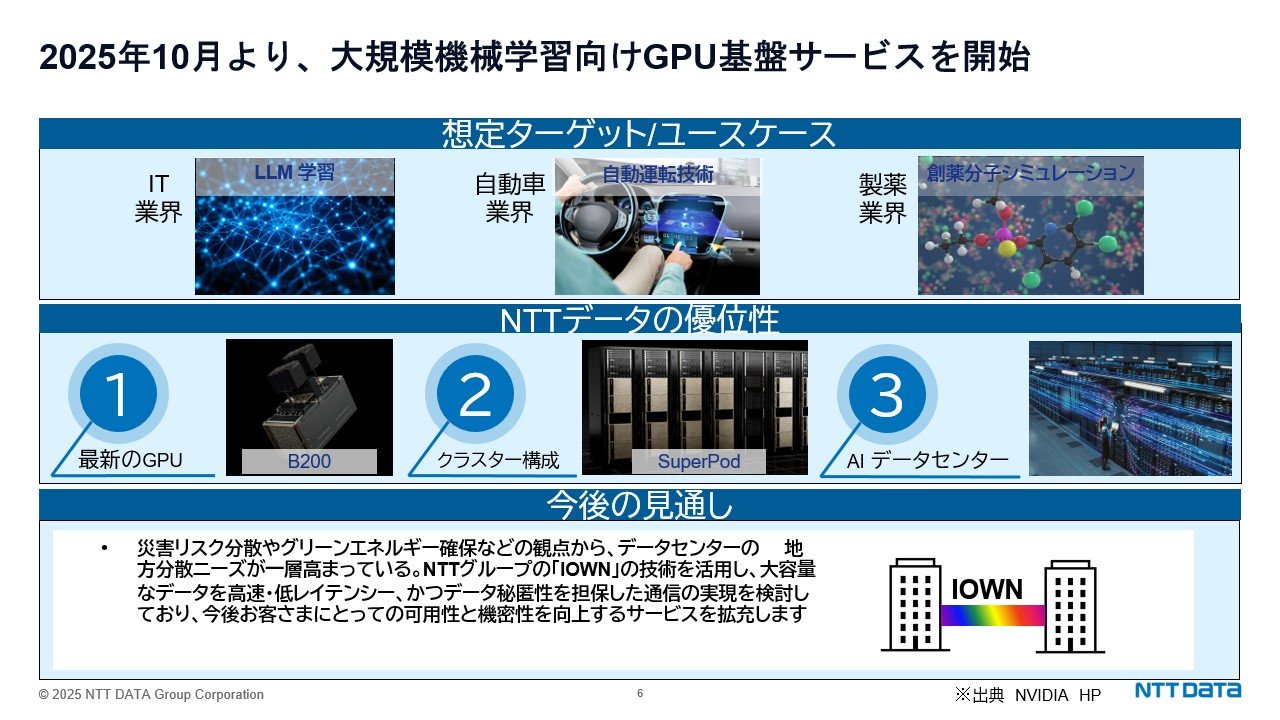

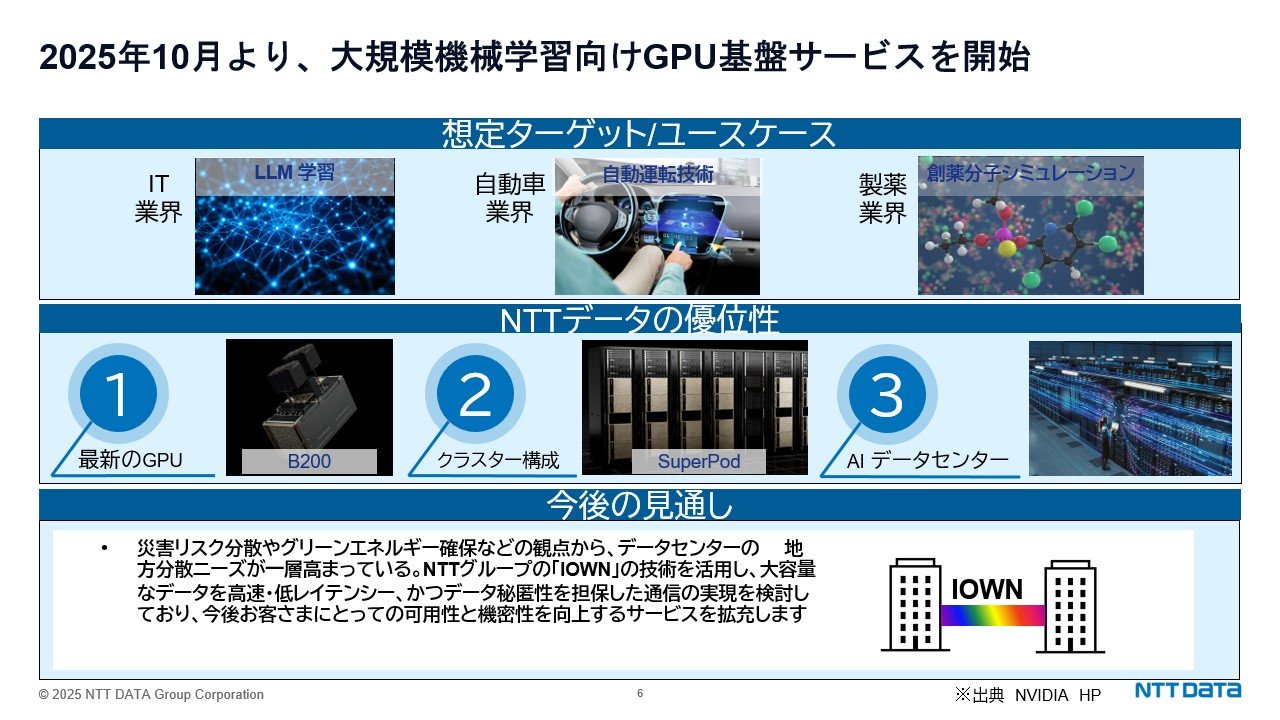

2025年3月にリリースを発表した大規模学習に向けた「SuperPOD」提供サービスもご紹介します。「SuperPOD」とは最低32台のGPUサーバを高速通信でつないで1つのシステムとして動作させるものです。ユースケースとしては、LLMの構築、自動運転技術関連、創薬における分子シミュレーションといった、大規模の計算リソースを必要とする高度な分野を想定しています。本システムの特徴として、最新のGPUであるNVIDIAのB200システムをベースとしていること、大規模クラスター構成であること、それらに対応したAIデータセンターで提供することがあげられます。また今後の展開としてはNTTグループのIOWNを使ってデータセンター間をつないでいく、分散型データセンター構想も掲げております。

NVIDIA最新GPU を活用した大規模機械学習向け基盤提供を開始

https://www.nttdata.com/global/ja/news/topics/2025/031900/

まとめ

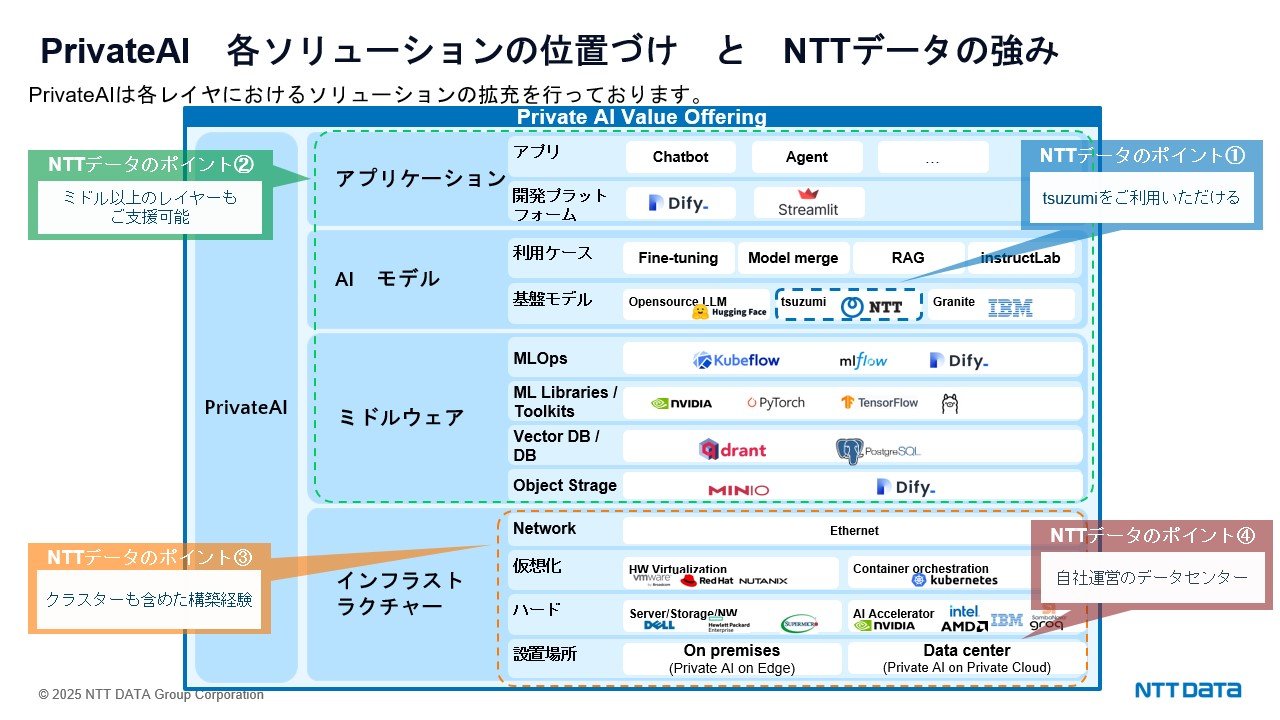

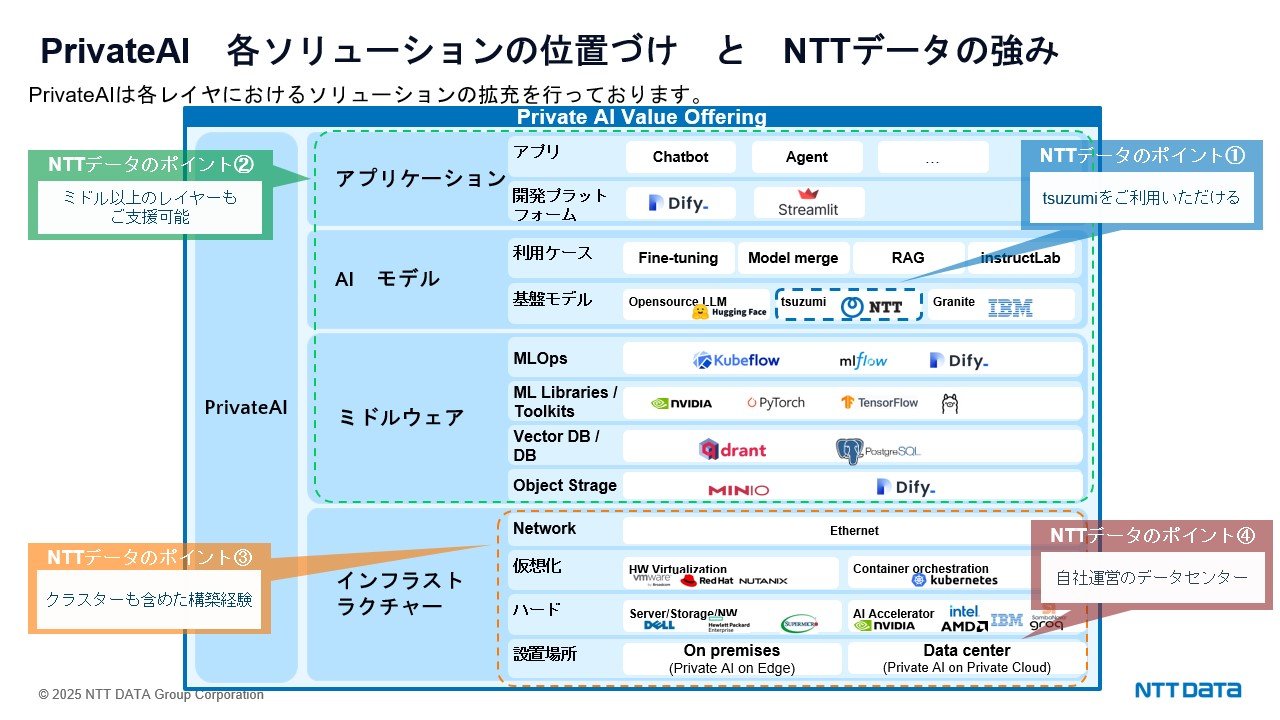

さまざまなサービスを紹介してきましたが、そのベースとなるNTTデータの強みは大きく4つあります。

➀NTTグループ独自のLLMであるtsuzumiをご利用いただけること、➁そして今回ご紹介したインフラ基盤に限らず上位のミドルウェア、AIモデル、アプリケーションもご支援可能であるということ、③高性能GPUを束ねるクラスターの構築経験およびGPUに精通したノウハウを蓄積していること、④さらにはAIニーズに対応できる自社運営のデータセンターを保有していることといった特徴があげられます。

こうした強みを活かして、お客様の課題解決をご支援させていただければと思います。